日記ブログ、または雑多なメモ

ゼェハァゼェハァ……

なんとかslog missingなプールをimportできた。

とりあえず、メモ。

状況としては、

・logを別デバイスにしたzfsプールを作った

・logデバイスを物理的にぶっとばした(ディスクを外す、フォーマットしてしまう等)

・importできていた頃の記憶を含んだキャッシュファイル(zpool.cache)もない

・以上の結果「device missing」でプールがimportできない

という状態からの復帰。 (キャッシュファイルがある場合はlogfix、もしくはzpool -Fオプションで回復可能。 かも)

この状況でなぜimportできないかというと、

「プールの基本構成に必要なtop-level のデバイスが足りないので端からimportできません」

つまりslogデバイス(分離されたlogデバイス)はプールに必要不可欠な「top-level device」扱いされているということ。 しかし、実際はzfsとしてはslogデバイスがなくても問題なく動く仕組みのはず。

「そもそもslogデバイスがtop levelデバイス扱いになるなんて聞いとらんわっ!!」

などと今さら怒っても仕方がないので調べてみると、kernel内でプールの全デバイス(vdev)のguidの合計値(guid sum)のチェックを行い、必要なデバイスが足りているかどうかの合否を出しているらしいのがわかった。 slogデバイスのguid1個分が足りないのでimportしないわけである。 できないわけではなく、その他暗号関係の都合の絡みで現状「しない」だけらしいので、無理矢理無効化して読み込ませればいいんでないかということで、やってみる。

disabling vdev guid sum in kernel/ vdev guid sumの無効化

kernelソースツリーの「usr/src/uts/common/fs/zfs/spa.c」のspa_load_implの中の、

の部分で「guid sum」をチェックしている模様。

ここをコメントするなり削除するなりして「guid sum」チェックを無効にしてみる。 いじったzfsドライバをビルド・インストールして再起動。 念のためその際ZILは無効にしておく。

このままだと「guid sum」チェックはすり抜けられるものの、「存在しない存在するはずのデバイス」にアクセスしにいこうとするためか、今度は「corrupted」が返ってくる。 それを抑制するために、rootデバイスのzfsラベル内の「Name/Value Pairs」の中の「vdev_children」の値「2」を「1」に変更してみる(詳細は後述)。

この時点で、わざとlogをぶっとばした実験用のjunkpoolでは、問題なくimportできた。

が、しかし。

肝心の本番のraidz2プールの方がヘッダを飛ばしたか何かで(実はkernel改造実験中に一度、作業用zfsルートドライブを読み込み不能->破壊したことがある)、importしようとするとkernel panic。 「zdb -e -uuu #id」をかけるとuberblock情報を表示するはずが何も表示してくれない。 ここでかなーーり悩み凹みつつ、zfsのヘッダブロックについてもう少しつっこんで調べてみた。

ZFS Label

デバイスにおけるzfsのラベルマップ

zfsのヘッダブロック、正確には「ラベル」はドライブの先頭部分にL0/L1(512kB)、後部ににL2/L3(512kB)とあって、それぞれ4個同じもの(複製)である。 5ドライブでRAIDしてる場合は山の様に同じラベルがあることになるが、それだけあるうちどれが優先されるのかといえば、まず全体の情報を得るのにL0が読まれるらしい。

その次に、ラベル内のuberblockが読み込まれないといけないはずなのだが、各ドライブのラベル内で「同じtxgを持った正常なuberblock」が読み込まれることによって次のimport動作に移るっぽい。 uberblockはラベルの128kB以降に1kBのコピーが128個ラウンドロビンで配置され、その中の「一番数字の大きいtxg」を持ったブロックが「active」扱いになる。 その「active扱いになってるuberblock」が死亡しているとimportできなくなる。 らしい。

実際にラベルL0の中身を見てみると、とりたてて破壊されてる風もないし、となるとuberblockのrootbpの参照先が消えているか、もしくは参照そのものが壊れているかのどっちかと思われるが、前者だとお手上げ、後者ならラウンドロビンの過去のuberblockからなんとか戻せるかもしれない。

そんなこんなでラベルの中身をhexeditでいじるはめになる。

make backup ZFS Label image / ラベルいじり

まずオフィシャルの ドキュメントがとても参考になるので目を通す。

いじる前に各ドライブのL0/L1/L2/L3をddでバックアップ。

L0をちゃんと設定すれば他のラベルはあんまり関係ないっぽいのでL0だけバックアップすればいいと思われるが、何はともあれ念のために全部バックアップしておくのが得策。 ちなみに各ラベルは、他のドライブには使いまわせないようなので(試しに違うドライブのラベルを無理矢理ぶっこんでみたらところ、そのドライブはFaulted/Corruptになった)ちゃんとぞれぞれでバックアップしないといけない。

…

…

後ろ部分のラベルの見つけ方であるが、prtvtocでジオメトリを見て、

ub magic numberで無理矢理あたりをつけて探した。 512kBを切り出しhexeditで開き、0x4000番地から一つめの「Name/Value Pairs」が始まって、0x20000番地からuberblock、0x44000番地から二つ目の「Name/Value Pairs」、0x60000番地から二つ目のuberblockがあれば正解。 ちなみに今回のドライブは日立の2.5inch 250GBドライブが5台で、ジオメトリもラベルの配置も全部同じであった。

prtvtocによるとジオメトリは上のような状態。 実際に後ろのラベルがあったのはbs=512で488395776。 ということはzfsから見るドライブの末端は

ジオメトリよりもはみ出してるんだけど、いまひとつ規則性がわからん。

以上、バックアップしたイメージをさらにコピーして、そのコピーしたイメージで作業を行う。

change vdev_children to '1' in Name/Value Pairs / vdev_childrenの値変更

なんでこれをいじるかといえば、slogデバイスとrootのプールとを合わせて「top-levelのvdevが2個」ということで「2」になっているのだが、そのslogデバイスはもうない。 ので「1」にすればエラーなく読み込んでくれるんじゃないかという話。

hexeditでName/Value Pairsの該当部分を単純に「2」から「1」に変更する。

Name/Value Pairsの先頭部分。

赤字部分、上がtxg、下がvdev_children

reset active uberblock / active uberblockの変更

「zdb -e」でuberblockが表示されなかったりimportするとフリーズしたりする場合、「active uberblock」が壊れているとみられる。 ラウンドロビン128kBの中のどのブロックがactiveなのかといえば、txgの値が一番大きいものが「active扱い」になるらしい。 というわけで「txgの一番大きいuberblock」近辺をクリアして、いくつか遡ったブロック(ならば壊れていないだろうという期待/推定で)を残しておけばいいんぢゃね?ということで、該当部分をddなり手動なりで削除してから「Name/Value Pairs」の中のtxgをそれに合わせてみる。

ちなみに「Name/Value Pairs」の部分では「16 75 04(16進数 0x167504/10進数 1471748)」という表記だが、uberblockの中では「04 75 16」とオーダーが違うので注意。

uberblock先頭部分。

赤字がtxg。

ddで消去する場合は↑こんな感じ。

以上の作業を今回はraidz2なので最初の3ドライブ(3ドライブ以上生きてる必要があるので)についてやってみた。 根拠は無し。 zfs的には「best」なconfigを「自動的に採択」するらしいので、それに期待。 それぞれtxgが同じ(active uberblock)になるようにする。

write modified image back to device / いじったラベルを書き戻す

作業が終わったら、いじったラベルを各ドライブへ書き戻す。

その後「zdb -e -uuu #id」でuberblock内容が表示されれば復帰完了。 のはず。

ダメな場合はバックアップを書き戻してオフィシャルの対応を待つか、あきらめる。

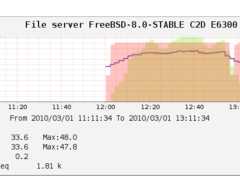

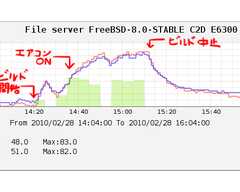

txgが1470344以降のuberblockを削除した結果、1470344まで巻き戻って復帰できた模様

junkpoolは実験用のUSBスティック。

tankが要救出のプール。

どちらもlogデバイスはなかったことになって見えるが、「zdb -e」で見るとちゃんとログデバイス名が残ってたりする

以上、復帰完了。

ところで、このようにして無理矢理importしたプールはslogデバイス抜きのguid sumが新たにコンフィグに保存されるのか、改造kernelでなくてもimportできるようになり、かつ普通に今まで通りそのまま使えるようである。 自分はなんだか気持ち悪いのでまたまたデータをバックアップしてプールを作り直した。

まあ、とりあえず……ファイルサーバを作っておきながら、バックアップデータを自分で消すというおバカな事態をなんとか回避できたらしい。

ものすごくアホなことでプールが読めなくなったzfsだが、中身を見てみると冗長性の鬼というかなんというか。 おかげで復帰できたっちゅうもんではある。 にしても、この「slogデバイスを飛ばすと問答無用で読めなくなる仕様」はなんとかしないと、次々とトラップにかかる人が出てくると思うんだが、どうなんだろう。

おまけ・ラベルの複製

ラベルの一部が壊れた場合、同じドライブの他のラベルをそのままコピーすればよし。

健康なラベルをddで抜きだし、壊れたラベルに上書きする。 うっかりifとofを逆にしたり、イメージへ書き込むときに「conv=notrunc」を忘れたりしないように注意。

おまけ2・後部ラベルの位置

ラベル情報の中の「asize」からデバイス最終端の位置がわかるんでないか?というこちらの記事を見て、計算してみた。

asize = 1250272215040

1250272215040 / 5 = 250054443008(5台分なので)

250054443008 / 512 = 488387584(1セクタ512バイト)

488396800 - 488387584 = 9216 (実際に見つけたデバイス最終端 - 上の計算結果)

記事と同じ数字が出た。

記事の「8192 + (asize/512)」という式をRAIDプールで考えると、

「8192 + (asize/512/台数)」になると思われるので当てはめてみると、

8192 + ( 1250272215040 / 512 / 5 ) = 488395776 = L2開始位置(+(512*2)=488396800 でデバイス最終端)

になる、と。 たまたま5ドライブのジオメトリが全く同じだから「なるほど」と思うが、そうでない場合どうなるのか。 たぶん、一番小さいジオメトリに合わせて全ドライブ同じボリュームサイズが自動的に構成されるはずなので、やっぱり同じ計算方法でいける……のかねぇ?

なんとかslog missingなプールをimportできた。

とりあえず、メモ。

状況としては、

・logを別デバイスにしたzfsプールを作った

・logデバイスを物理的にぶっとばした(ディスクを外す、フォーマットしてしまう等)

・importできていた頃の記憶を含んだキャッシュファイル(zpool.cache)もない

・以上の結果「device missing」でプールがimportできない

という状態からの復帰。 (キャッシュファイルがある場合はlogfix、もしくはzpool -Fオプションで回復可能。 かも)

この状況でなぜimportできないかというと、

「プールの基本構成に必要なtop-level のデバイスが足りないので端からimportできません」

つまりslogデバイス(分離されたlogデバイス)はプールに必要不可欠な「top-level device」扱いされているということ。 しかし、実際はzfsとしてはslogデバイスがなくても問題なく動く仕組みのはず。

「そもそもslogデバイスがtop levelデバイス扱いになるなんて聞いとらんわっ!!」

などと今さら怒っても仕方がないので調べてみると、kernel内でプールの全デバイス(vdev)のguidの合計値(guid sum)のチェックを行い、必要なデバイスが足りているかどうかの合否を出しているらしいのがわかった。 slogデバイスのguid1個分が足りないのでimportしないわけである。 できないわけではなく、その他暗号関係の都合の絡みで現状「しない」だけらしいので、無理矢理無効化して読み込ませればいいんでないかということで、やってみる。

disabling vdev guid sum in kernel/ vdev guid sumの無効化

kernelソースツリーの「usr/src/uts/common/fs/zfs/spa.c」のspa_load_implの中の、

1758 /* |

の部分で「guid sum」をチェックしている模様。

ここをコメントするなり削除するなりして「guid sum」チェックを無効にしてみる。 いじったzfsドライバをビルド・インストールして再起動。 念のためその際ZILは無効にしておく。

このままだと「guid sum」チェックはすり抜けられるものの、「存在しない存在するはずのデバイス」にアクセスしにいこうとするためか、今度は「corrupted」が返ってくる。 それを抑制するために、rootデバイスのzfsラベル内の「Name/Value Pairs」の中の「vdev_children」の値「2」を「1」に変更してみる(詳細は後述)。

この時点で、わざとlogをぶっとばした実験用のjunkpoolでは、問題なくimportできた。

が、しかし。

肝心の本番のraidz2プールの方がヘッダを飛ばしたか何かで(実はkernel改造実験中に一度、作業用zfsルートドライブを読み込み不能->破壊したことがある)、importしようとするとkernel panic。 「zdb -e -uuu #id」をかけるとuberblock情報を表示するはずが何も表示してくれない。 ここでかなーーり悩み凹みつつ、zfsのヘッダブロックについてもう少しつっこんで調べてみた。

ZFS Label

0kB |

256kB |

512kB |

4MB |

デバイスの尻-512kB |

デバイスの尻-256kB |

zfsのヘッダブロック、正確には「ラベル」はドライブの先頭部分にL0/L1(512kB)、後部ににL2/L3(512kB)とあって、それぞれ4個同じもの(複製)である。 5ドライブでRAIDしてる場合は山の様に同じラベルがあることになるが、それだけあるうちどれが優先されるのかといえば、まず全体の情報を得るのにL0が読まれるらしい。

その次に、ラベル内のuberblockが読み込まれないといけないはずなのだが、各ドライブのラベル内で「同じtxgを持った正常なuberblock」が読み込まれることによって次のimport動作に移るっぽい。 uberblockはラベルの128kB以降に1kBのコピーが128個ラウンドロビンで配置され、その中の「一番数字の大きいtxg」を持ったブロックが「active」扱いになる。 その「active扱いになってるuberblock」が死亡しているとimportできなくなる。 らしい。

実際にラベルL0の中身を見てみると、とりたてて破壊されてる風もないし、となるとuberblockのrootbpの参照先が消えているか、もしくは参照そのものが壊れているかのどっちかと思われるが、前者だとお手上げ、後者ならラウンドロビンの過去のuberblockからなんとか戻せるかもしれない。

そんなこんなでラベルの中身をhexeditでいじるはめになる。

make backup ZFS Label image / ラベルいじり

まずオフィシャルの ドキュメントがとても参考になるので目を通す。

いじる前に各ドライブのL0/L1/L2/L3をddでバックアップ。

L0をちゃんと設定すれば他のラベルはあんまり関係ないっぽいのでL0だけバックアップすればいいと思われるが、何はともあれ念のために全部バックアップしておくのが得策。 ちなみに各ラベルは、他のドライブには使いまわせないようなので(試しに違うドライブのラベルを無理矢理ぶっこんでみたらところ、そのドライブはFaulted/Corruptになった)ちゃんとぞれぞれでバックアップしないといけない。

# dd if=/dev/dsk/c5t0d0p0 bs=1k count=512 of=c5t0d0p0-l0l1.img #先頭部分512kB

# dd if=/dev/dsk/c5t0d0p0 bs=1k count=512 skip=244197888 of=c5t0d0p0-l2l3.img #後ろ部分512kB # dd if=/dev/dsk/c5t1d0p0 bs=1k count=512 of=c5t1d0p0-l0l1.img #2個めのドライブ…# dd if=/dev/dsk/c5t1d0p0 bs=1k count=512 skip=244197888 of=c5t1d0p0-l2l3.img…

…

後ろ部分のラベルの見つけ方であるが、prtvtocでジオメトリを見て、

# dd if=/dev/dsk/c5t0d0p0 bs=1k skip=240000000 |od -x|grep "b10c 00ba"ub magic numberで無理矢理あたりをつけて探した。 512kBを切り出しhexeditで開き、0x4000番地から一つめの「Name/Value Pairs」が始まって、0x20000番地からuberblock、0x44000番地から二つ目の「Name/Value Pairs」、0x60000番地から二つ目のuberblockがあれば正解。 ちなみに今回のドライブは日立の2.5inch 250GBドライブが5台で、ジオメトリもラベルの配置も全部同じであった。

* Dimensions:

* 512 bytes/sector

* 63 sectors/track

* 255 tracks/cylinder

* 16065 sectors/cylinder

* 30401 cylinders

* 30399 accessible cylinders* Unallocated space:

* First Sector Last

* Sector Count Sector

* 16065 488343870 488359934prtvtocによるとジオメトリは上のような状態。 実際に後ろのラベルがあったのはbs=512で488395776。 ということはzfsから見るドライブの末端は

488395776+(512*2)=488396800?ジオメトリよりもはみ出してるんだけど、いまひとつ規則性がわからん。

以上、バックアップしたイメージをさらにコピーして、そのコピーしたイメージで作業を行う。

change vdev_children to '1' in Name/Value Pairs / vdev_childrenの値変更

なんでこれをいじるかといえば、slogデバイスとrootのプールとを合わせて「top-levelのvdevが2個」ということで「2」になっているのだが、そのslogデバイスはもうない。 ので「1」にすればエラーなく読み込んでくれるんじゃないかという話。

hexeditでName/Value Pairsの該当部分を単純に「2」から「1」に変更する。

00004000 01 01 00 00 00 00 00 00 00 00 00 01 00 00 00 24 00 00 00 20 00 00 00 07 76 65 72 73 69 6F 6E 00 ...............$... ....version. |

reset active uberblock / active uberblockの変更

「zdb -e」でuberblockが表示されなかったりimportするとフリーズしたりする場合、「active uberblock」が壊れているとみられる。 ラウンドロビン128kBの中のどのブロックがactiveなのかといえば、txgの値が一番大きいものが「active扱い」になるらしい。 というわけで「txgの一番大きいuberblock」近辺をクリアして、いくつか遡ったブロック(ならば壊れていないだろうという期待/推定で)を残しておけばいいんぢゃね?ということで、該当部分をddなり手動なりで削除してから「Name/Value Pairs」の中のtxgをそれに合わせてみる。

ちなみに「Name/Value Pairs」の部分では「16 75 04(16進数 0x167504/10進数 1471748)」という表記だが、uberblockの中では「04 75 16」とオーダーが違うので注意。

00021000 0C B1 BA 00 00 00 00 00 16 00 00 00 00 00 00 00 04 75 16 00 00 00 00 00 FC 18 7F 2C 12 E5 B5 19 .................u.........,.... |

# dd if=/dev/zero bs=1k seek=128 count=1 conv=notrunc of=c5t0d0p0-l0l1-copy.img #L0の先頭のuberblockを1個消去する場合

# dd if=/dev/zero bs=1k seek=131 count=125 conv=notrunc of=c5t0d0p0-l0l1-copy.img #L0の先頭の3個のuberblockを残してあとは消去する場合# dd if=/dev/zero bs=1k seek=129 count=127 conv=notrunc of=c5t0d0p0-l0l1-copy.img #L0の先頭以外のuberblockを全部消去する場合ddで消去する場合は↑こんな感じ。

以上の作業を今回はraidz2なので最初の3ドライブ(3ドライブ以上生きてる必要があるので)についてやってみた。 根拠は無し。 zfs的には「best」なconfigを「自動的に採択」するらしいので、それに期待。 それぞれtxgが同じ(active uberblock)になるようにする。

write modified image back to device / いじったラベルを書き戻す

作業が終わったら、いじったラベルを各ドライブへ書き戻す。

# dd of=/dev/dsk/c5t0d0p0 bs=1k count=512 conv=notrunc if=c5t0d0p0-l0l1-copy.img #先頭部分512kB

# dd of=/dev/dsk/c5t0d0p0 bs=1k count=512 seek=244197888 conv=notrunc if=c5t0d0p0-l2l3-copy.img # 後ろ部分512kB(L2/L3も更新したい場合)

その後「zdb -e -uuu #id」でuberblock内容が表示されれば復帰完了。 のはず。

ダメな場合はバックアップを書き戻してオフィシャルの対応を待つか、あきらめる。

# zdb -e -uuu 7176844548823255674 |

# zpool import |

以上、復帰完了。

ところで、このようにして無理矢理importしたプールはslogデバイス抜きのguid sumが新たにコンフィグに保存されるのか、改造kernelでなくてもimportできるようになり、かつ普通に今まで通りそのまま使えるようである。 自分はなんだか気持ち悪いのでまたまたデータをバックアップしてプールを作り直した。

まあ、とりあえず……ファイルサーバを作っておきながら、バックアップデータを自分で消すというおバカな事態をなんとか回避できたらしい。

ものすごくアホなことでプールが読めなくなったzfsだが、中身を見てみると冗長性の鬼というかなんというか。 おかげで復帰できたっちゅうもんではある。 にしても、この「slogデバイスを飛ばすと問答無用で読めなくなる仕様」はなんとかしないと、次々とトラップにかかる人が出てくると思うんだが、どうなんだろう。

おまけ・ラベルの複製

ラベルの一部が壊れた場合、同じドライブの他のラベルをそのままコピーすればよし。

健康なラベルをddで抜きだし、壊れたラベルに上書きする。 うっかりifとofを逆にしたり、イメージへ書き込むときに「conv=notrunc」を忘れたりしないように注意。

# dd of=label.img bs=1k count=256 if=c5t0d0p0-l0l1-copy.img #L0を抜きだす# dd of=label.img bs=1k count=256 skip=256 if=c5t0d0p0-l0l1-copy.img #L1を抜きだす# dd if=label.img bs=1k count=256 conv=notrunc of=c5t0d0p0-l0l1-copy.img #L0に上書き

# dd if=label.img bs=1k count=256 seek=256 conv=notrunc of=c5t0d0p0-l0l1-copy.img #L1に上書きおまけ2・後部ラベルの位置

ラベル情報の中の「asize」からデバイス最終端の位置がわかるんでないか?というこちらの記事を見て、計算してみた。

asize = 1250272215040

1250272215040 / 5 = 250054443008(5台分なので)

250054443008 / 512 = 488387584(1セクタ512バイト)

488396800 - 488387584 = 9216 (実際に見つけたデバイス最終端 - 上の計算結果)

記事と同じ数字が出た。

記事の「8192 + (asize/512)」という式をRAIDプールで考えると、

「8192 + (asize/512/台数)」になると思われるので当てはめてみると、

8192 + ( 1250272215040 / 512 / 5 ) = 488395776 = L2開始位置(+(512*2)=488396800 でデバイス最終端)

になる、と。 たまたま5ドライブのジオメトリが全く同じだから「なるほど」と思うが、そうでない場合どうなるのか。 たぶん、一番小さいジオメトリに合わせて全ドライブ同じボリュームサイズが自動的に構成されるはずなので、やっぱり同じ計算方法でいける……のかねぇ?

- C'sGallery Blogっぽく見えるシステム3.2 -

小武 (管理人) eta2@tim.hi-ho.ne.jp

小武 (管理人) eta2@tim.hi-ho.ne.jp