日記ブログ、または雑多なメモ

忘れてた。

今のうちにディスクにシールでも貼っておかないと、どれがどれかわからなくなるので一本ずつ線を抜いて確かめながらシール貼り。

よく考えたらケーブルにも貼らないと意味がない。

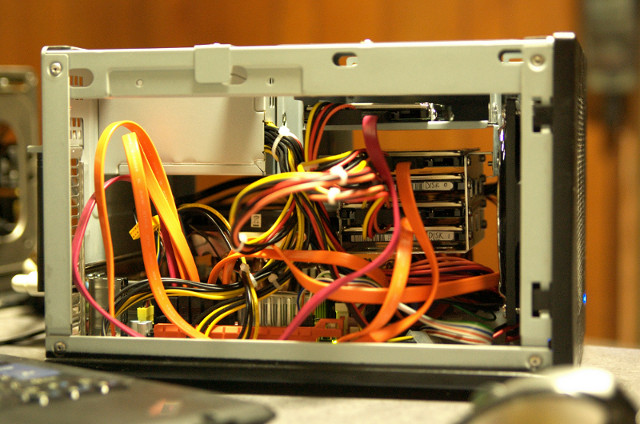

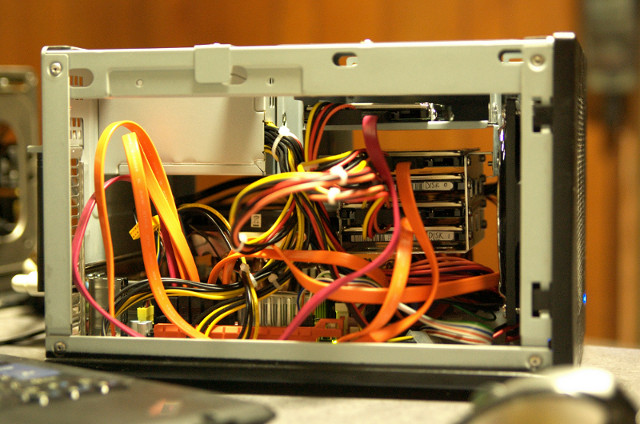

見事に5台載っております。 かようにHDD群のまん前に巨大ファンが(偶然)まわっているので熱的な心配は無いと思われる。

一本抜いて、戻してリブート……と繰り返していて、3本目を抜いたところでなぜかフリーズ、リブートしても「poolが見つかりません」と怒られた。 なんで中途半端に3本目のHDDだけダメなんじゃああと思ったら、その前の二本分の修復をしていなくて3本イカれた事になり、フリーズしたということに気がついた。 自動でさくっと直してくれるものとばかり思っていたのだが。

一本抜いて、戻してリブートしたら、

とすればいいわけですな。 なるほど。

ところで、RAID-5/6における機械的信頼性について、今回の場合はRAID-6で「3台で容量増加」「2台が担保」というシステムになっているが、

「もし2台がおしゃかになったときは、残り3台の故障確率は通常の三倍で非常に危険な状態」

ということでもある。 故障確率3倍と担保が2台だと若干分が悪い気はする。 ここに1台スペアを足すとちょうどよいところかもだが、実験するにしてもesata接続できる外箱を買ってこないとだめだ。 まあ、大事なのは1台お釈迦になったときに「すぐに交換すること」ですな。

台数が増えると故障確率が倍になるのは確かなのだが、それぞれが同時期に壊れる確率というのはまた別な話だと思うので単純計算はできないかもである。 同ロットで同じ条件で使用、となると同じ末期を歩む可能性もなくもないが、今回は5台ほぼ同形式だが同ロットではないのでどうなるか見ものではある。 人柱である。

ちなみに今の5台は、

こんな感じで ad4、ad6、ad10 は同ロットかも。 ただ、RAID的にはできれば同ロットを使うべし、ということになっているのでどっちやねん、ちゅう話ではある。

ところでたった今、atacontrolでの正しいdetach、attachのやり方がわかったので、ついでにad4をdetach、attachしてみた。

すると、zpool statusでREMOVEDになった。

そこで、zpool clear zrootした。

修復中。 10秒くらい切り離しただけなのだが修復に2時間半かかると書いてある。 プールに続々とバックアップしながらだからなのかもしれないが。

しかし数分後もう一回みてみると、

あと4分になった。 だいぶ適当な計算らしい。

終わった。 10分で修復が終わった様である。 ふむふむ。 まったくおもしろいシステムだ。

見事に5台載っております。 かようにHDD群のまん前に巨大ファンが(偶然)まわっているので熱的な心配は無いと思われる。

一本抜いて、戻してリブート……と繰り返していて、3本目を抜いたところでなぜかフリーズ、リブートしても「poolが見つかりません」と怒られた。 なんで中途半端に3本目のHDDだけダメなんじゃああと思ったら、その前の二本分の修復をしていなくて3本イカれた事になり、フリーズしたということに気がついた。 自動でさくっと直してくれるものとばかり思っていたのだが。

一本抜いて、戻してリブートしたら、

# zpool clear zrootとすればいいわけですな。 なるほど。

ところで、RAID-5/6における機械的信頼性について、今回の場合はRAID-6で「3台で容量増加」「2台が担保」というシステムになっているが、

「もし2台がおしゃかになったときは、残り3台の故障確率は通常の三倍で非常に危険な状態」

ということでもある。 故障確率3倍と担保が2台だと若干分が悪い気はする。 ここに1台スペアを足すとちょうどよいところかもだが、実験するにしてもesata接続できる外箱を買ってこないとだめだ。 まあ、大事なのは1台お釈迦になったときに「すぐに交換すること」ですな。

台数が増えると故障確率が倍になるのは確かなのだが、それぞれが同時期に壊れる確率というのはまた別な話だと思うので単純計算はできないかもである。 同ロットで同じ条件で使用、となると同じ末期を歩む可能性もなくもないが、今回は5台ほぼ同形式だが同ロットではないのでどうなるか見ものではある。 人柱である。

ちなみに今の5台は、

Duke# atacontrol list |

こんな感じで ad4、ad6、ad10 は同ロットかも。 ただ、RAID的にはできれば同ロットを使うべし、ということになっているのでどっちやねん、ちゅう話ではある。

ところでたった今、atacontrolでの正しいdetach、attachのやり方がわかったので、ついでにad4をdetach、attachしてみた。

# atacontrol detach ata2

# atacontrol attach ata2すると、zpool statusでREMOVEDになった。

Duke# zpool status |

そこで、zpool clear zrootした。

Duke# zpool status |

修復中。 10秒くらい切り離しただけなのだが修復に2時間半かかると書いてある。 プールに続々とバックアップしながらだからなのかもしれないが。

しかし数分後もう一回みてみると、

Duke# zpool status |

あと4分になった。 だいぶ適当な計算らしい。

Duke# zpool status |

終わった。 10分で修復が終わった様である。 ふむふむ。 まったくおもしろいシステムだ。

- C'sGallery Blogっぽく見えるシステム3.2 -

小武 (管理人) eta2@tim.hi-ho.ne.jp

小武 (管理人) eta2@tim.hi-ho.ne.jp